两篇相关文章:

学习记录:

1. 卷积神经网络基础单元

1.1 卷积(convolution)

- 卷积的计算方式

- http://deeplearning.stanford.edu/wiki/index.php/

- 或参考第二篇文章,有很简明的描述;

- 卷积核与通道、分辨率的关系

- 每个卷积核覆盖全部输入通道;

- 每个卷积核的结果为一个输出通道;

- 根据padding,可选地改变分辨率;

- 卷积的作用和设计思路

- 滤波(kernel-size, stride);

- 局部相关性(kernel-size);

- 中心感受野(padding, stride);

1.2 激活函数(activation)

- 参考知乎文章:https://zhuanlan.zhihu.com/p/21462488?refer=intelligentunit

- 激活函数的设计思想:非线性扭曲

- 常见激活函数

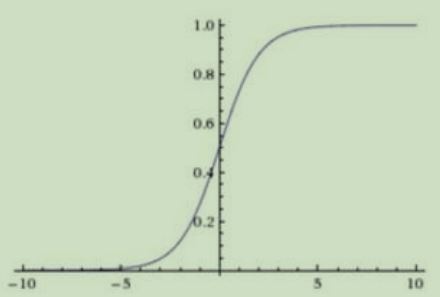

- Sigmoid

- ReLU/PReLU/SeLu

- Tanh

1.3 池化(pooling)

- 原理:http://deeplearning.stanford.edu/wiki/index.php/%E6%B1%A0%E5%8C%96

- 覆盖所有通道,但不改变通道数量;降低分辨率,减少信息量;

- 作用:信息保留(avg_pool)与过滤( max_pool);

- 平移不变性(stride);

1.4 批归一化(batch normalization)

- 原理:https://blog.csdn.net/shuzfan/article/details/50723877

- 归一化为0均值和单位方差,有利于加速收敛;

- 对应的激活函数:sigmoid、ReLU;

1.5 Dropout

- 原理:https://zhuanlan.zhihu.com/p/21560667

- 作用:增加随机扰动,减少过拟合,代价是收敛变慢;